【論文メモ】ファクトチェックを必要とするニュース記事の探索の支援

ファクトチェックを必要とするニュース記事の探索の支援

- 田上翼, 浅野広樹 (東北大), 楊井人文, 山下亮 (日本報道検証機構), 小宮篤史, 藤村厚夫 (スマートニュース), 町野明徳 (フリー), 乾健太郎 (東北大)

- 言語処理学会第24回年次大会(NLP2018)

- http://anlp.jp/proceedings/annual_meeting/2018/pdf_dir/B3-3.pdf

どんなもの?

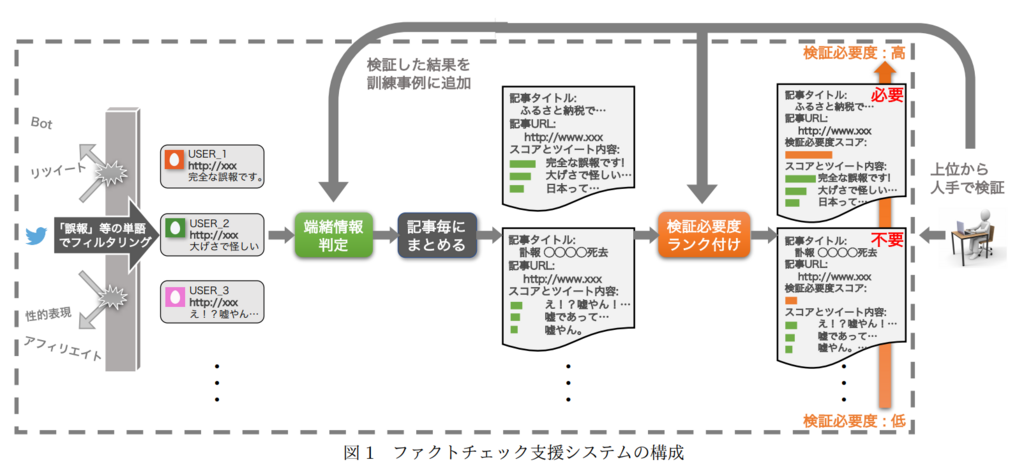

- ファクトチェックの必要性を示唆する情報(=「端緒情報」)の探索を自動化し,人手による要検証記事探索作業を技術的に支援する仕組みを構築

- Twitterの投稿を対象に,そこから端緒情報の可能性が高い投稿を自動抽出し,それらの情報に基づいてニュース記事を検証必要度の観点からランキングする

先行研究と比べてどこがすごい?

インターネット上の誤情報を検出する研究は行われているものの [1, 2, 9],幅広いドメインから端緒情報を抽出し,要検証記事を収集する研究は本研究が初

技術や手法のキモはどこ?

どうやって有効だと検証した?

データセット

- 朝日新聞デジタル,産経ニュース,日経電子版,毎日新聞のニュース・情報サイト,YOMIURI ONLINEのいずれかの媒体の記事 URL を含むツイートを 20,000 件抽出

- 人手で各ツイートが端緒情報であるか判定

- 正例:606 件(全体の 3.03%)

- 負例:正例でなく,bot によるツイートや,記事の本文やタイトルを引用しているだけでないツイートのうち 2,851件

分類器(5種類)

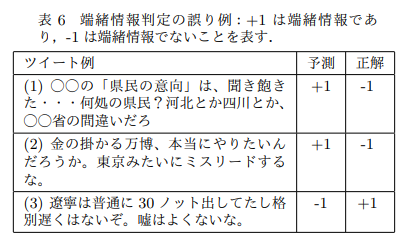

議論はある?

- 単なる皮肉

- 指摘の対象が記事でなく政府

- 「嘘」は日常で使いやすい

次に読むべき論文は?

NULL

【論文メモ】プレイデータからのサッカーの速報テキスト生成

プレイデータからのサッカーの速報テキスト生成

先行研究と比べてどこがすごい?

- テキスト生成課題で広く用いられる encoder-decoder[6]モデルは, 選手名やチーム名のような低頻度な単語に強く影響を受け,プレイデータについて正しく言及するようなテキストが出力できないという問題点があった

- 提案手法では出力となる速報テキストにおける言語表現を汎化した上で学習し,それらの復元方法も同時に学習することで,プレイデータにより即した出力結果を得た

技術や手法のキモはどこ?

どうやって有効だと検証した?

- Premier League1の 15/16 シーズンの全試合のデータを利用

議論はある?

汎化タグに変換するだけでなく,単語の結合も行うことで,生成文の質が上がっていた

次に読むべき論文は?

encoder-decoder[6]モデル

[6] Ilya Sutskever, Oriol Vinyals, and Quoc V. Le. Sequence to sequence learning with neural networks. arXiv:1409.3215, 2014.

【論文メモ】会話によるニュース記事伝達のための間の調整

会話によるニュース記事伝達のための間の調整

どんなもの?

- 会話によるニュース記事伝達において,割り込みを許容しながら快適なリズムで会話を進行させるための間の調整について検討

- ユーザーが理解しやすく,発話中でも割り込みやすい間の実現を目指す

先行研究と比べてどこがすごい?

システム発話の工夫によって相互行為を活性化させようとする観点では,聞き手からの相槌やうなずきなどを誘発する研究が行われているが,これも韻律制御に留まっており,間の制御までは扱っていない [3]

技術や手法のキモはどこ?

- コーパスの作成

- テクノロジー系のニュース記事 100 個を人手で要約・口語化し,発話のシナリオを作成した.このシナリオを女性声優に発話させ,その発話音声を収録した

- 発話内文節間の間の推定

- 双方向 LSTMで学習

- 発話間の間の推定

- BayesianRidgeモデル

どうやって有効だと検証した?

- 音声合成器として AITalk(話者:のぞみ)を使用し,間の調整を行ったときと行わなかったときでどちらが「質問しやすかったか」「相槌を打ちやすかったか」「頭に入りやすかったか」について評価を行った

- どちらについても調整を行った間の方が良いという結果が得られた

議論はある?

- 個人ごとの間の調整や多重タスク下での間の取り方について検討

- 抑揚の付け方や話速といった韻律情報を総合的に制御できる仕組みについても検討

次に読むべき論文は?

NULL

【論文メモ】複数エンコーダを用いたヤフートピックス見出し候補生成

複数エンコーダを用いたヤフートピックス見出し候補生成

- 小林健 (ヤフー), 小林隼人 (ヤフー/理研AIP), 村尾一真, 増山毅司 (ヤフー)

- 言語処理学会第24回年次大会(NLP2018)

- http://anlp.jp/proceedings/annual_meeting/2018/pdf_dir/A1-3.pdf

どんなもの?

先行研究と比べてどこがすごい?

技術や手法のキモはどこ?

- 複数エンコーダを利用する「Multimodal Attention モデル」の改良

- 入力

- 記事リード文

- 記事タイトル

- 出力

- トピックス見出し

議論はある?

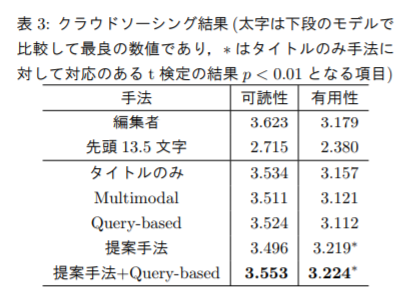

実験結果の細部について議論

次に読むべき論文は?

- Multimodal Attention モデル

- [5] Chiori Hori, Takaaki Hori, Teng-Yok Lee, Ziming Zhang, Bret Harsham, John R. Hershey, Tim K. Marks, and Kazuhiko Sumi. Attention-Based Multimodal Fusion for Video Description. In ICCV, 2017.

- Query-based Attention モデル

- [4] Preksha Nema, Mitesh M. Khapra, Anirban Laha, and Balaraman Ravindran. Diversity driven attention model for query-based abstractive summarization. In ACL, pp. 1063–1072, 2017.

【論文メモ】ニュースからのトピックに関するストーリーラインの生成

ニュースからのトピックに関するストーリーラインの生成

- 谷口祐太郎, 小林哲則, 林良彦 (早大)

- 言語処理学会第24回年次大会(NLP2018)

- http://anlp.jp/proceedings/annual_meeting/2018/pdf_dir/P7-14.pdf

どんなもの?

ニュースコーパスからトピック (知りたい事柄) に関連するテーマを抽出し,そのテーマに関連する文が時系列順に並んだ文集合 (ストーリーライン) を出力するシステムを提案

先行研究と比べてどこがすごい?

- 複数の文からなる文書に対して,あるキーワードに基づいて重要文抽出を行う [5] 試みはあるが,出力される文集合は 1 つのみである

- 知りたい事柄についての情報の中には様々なテーマがあるため,テーマを自動で抽出し,文集合を複数出力することが望ましい

技術や手法のキモはどこ?

議論はある?

- 適切な文集合が一定の Precision で得られることを示し,Recall を改善する課題を明確化した

- 本稿では触れていない「タイトル生成」の手法を提案しシステム全体を実装

次に読むべき論文は?

NULL

【論文メモ】検索エンジンによる上位検索ページを情報源とするフェイクニュース自動検出のためのデータセット作成

【論文メモ】ブートストラップ法による科学ニュース記事からの雑誌名抽出

ブートストラップ法による科学ニュース記事からの雑誌名抽出

- 菊地真人, 吉田光男, 梅村恭司 (豊橋技科大)

- 言語処理学会第24回年次大会(NLP2018)

- http://anlp.jp/proceedings/annual_meeting/2018/pdf_dir/P11-6.pdf

どんなもの?

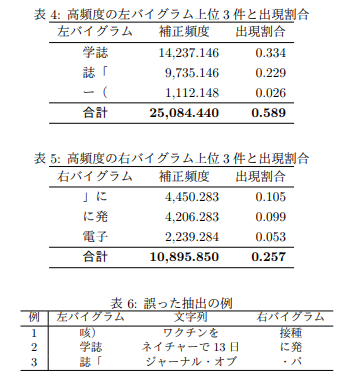

日本語の科学ニュース記事では,研究成果がわかりやすく述べられるが,出典となる文献情報は明記されない傾向にある.このことは,読者が研究の詳細を知ることへの障壁となっている.一方,研究内容が掲載された雑誌名は記事中に明記されることが多く,雑誌名を自動抽出することで対象の文献情報を探索する手がかりが得られる.

- 日本語の科学ニュース記事からの雑誌名抽出に取り組み,得られた雑誌名をリスト化する

- 雑誌名が特定の文脈に出現しやすいという仮定を立て,雑誌名抽出に対してこの仮説を裏付けた

先行研究と比べてどこがすごい?

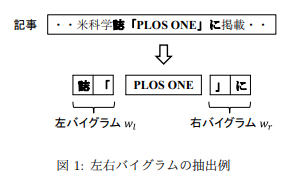

- 代表的な先行研究では,ブートストラップ法を採用しているが,固有表現抽出のパターンマッチに利用するパターンは左右の文脈のうち,どちらか一方である

- 本研究で提案する雑誌名抽出は,雑誌名の両側から学習した文脈をパターンとして利用するところが特徴である

- 日本語ならではの特徴

技術や手法のキモはどこ?

- 雑誌名は多種多様で,外国語の雑誌名を日本語の記事で掲載する場合は外来語として扱わず,発音に文字を当てはめて翻訳することが多い

- 記事を書いた著者によって雑誌名の表記ゆれが起こる

- ブートストラップ法[1, 2, 3] に基づいて科学ニュース記事からの雑誌名を抽出する

- ブートストラップ法は,人手で付与したシードと呼ばれる少数の固有表現を教師データとして,固有表現の抽出と辞書の拡充を交互に繰り返す

- 少数の固有表現をもとに多くの固有表現を抽出できる

どうやって有効だと検証した?

ウェブから収集した科学ニュース記事から雑誌名を抽出し,提案手法の性能を定量的に評価

- 反復の1回目では,適合率が 0.8 以上と高く,部分再現率も 0.5 を超えていた

- 雑誌名を抽出する手がかりとして左右バイグラムを使うことは有効である

- 反復の 2 回目では新たに得られた雑誌名が半減し,適合率が 0.2 ほど低下したにもかかわらず部分再現率はほとんど向上しなかった

- ブートストラップ法で高い F 値を維持したまま,雑誌名を抽出するためには工夫が必要ということが示唆された

議論はある?

次に読むべき論文は?

ブートストラップ法

[1] E. Riloff and R. Jones. Learning dictionaries for information extraction by multi-level bootstrapping. In AAAI, pp. 474–479, 1999.